긴 대화에서 AI 모델이 느려지는 경험, 해보셨죠? 방대한 텍스트 처리엔 막대한 연산 자원이 필요해요. 최근 중국 AI 기업 딥시크(DeepSeek)가 희소 어텐션이라는 혁신 기술로 AI 처리 비용을 최대 50%까지 절감할 수 있다고 밝혀 큰 주목을 받고 있답니다. 어떤 기술인지 함께 알아봐요!

AI 모델의 숨겨진 병목 현상, ‘어텐션’은 무엇일까요?

우리가 ChatGPT 같은 AI와 대화할 때, AI는 단순히 단어를 나열하는 것이 아니라 문맥을 이해하고 가장 적절한 답변을 찾아내요. 이때 핵심적인 역할을 하는 것이 바로 ‘어텐션(Attention)’ 메커니즘이랍니다. 어텐션은 문장 속 단어들이 서로 어떤 관계를 가지는지 파악해서 전체적인 의미를 구성하는 기술인데요. 예를 들어, “은행이 금리를 인상했다”는 문장에서 ‘은행’이 ‘강가’의 은행이 아닌 ‘금융기관’의 은행임을 파악하는 데 어텐션이 사용되죠.

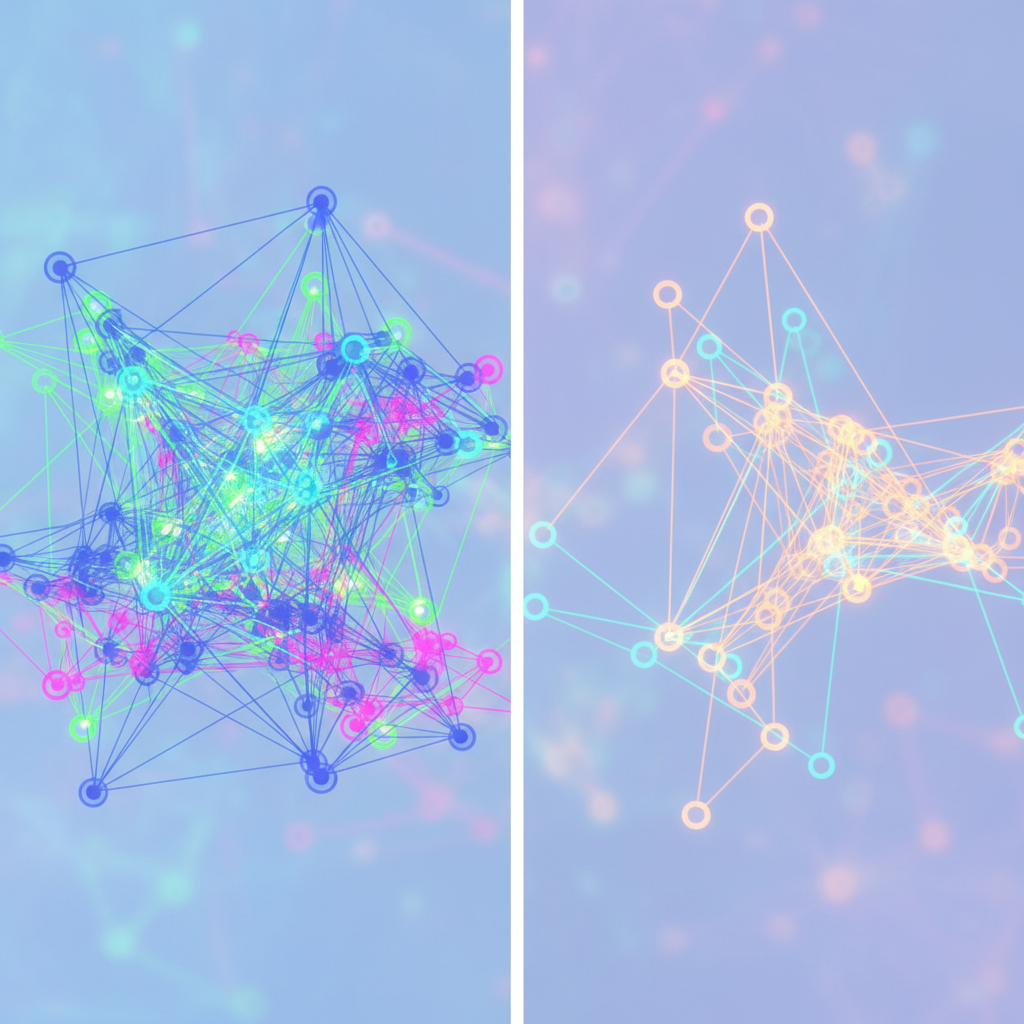

문제는 이 어텐션 메커니즘이 처음 개발된 트랜스포머(Transformer) 아키텍처에서 모든 단어의 관계를 일일이 확인하는 방식으로 작동한다는 점이에요. 만약 1,000개의 단어가 있는 긴 문장을 AI에 입력하면, 1,000 x 1,000, 즉 100만 개의 관계를 계산해야 합니다. 10,000개 단어라면 1억 개의 관계가 되죠. 이렇게 단어 수가 늘어날수록 계산량이 기하급수적으로(제곱에 비례하여) 증가하는데, 이 때문에 긴 대화나 장문 처리에서 AI 모델이 느려지는 ‘병목 현상’이 발생하게 된답니다.

희소 어텐션, 모든 단어를 볼 필요는 없어요!

이러한 어텐션의 병목 현상을 해결하기 위해 등장한 개념이 바로 희소 어텐션(Sparse Attention)이에요. 기존 어텐션이 모든 단어 쌍의 관계를 계산했다면, 희소 어텐션은 이름처럼 ‘희소하게’, 즉 모든 관계를 다 보지 않고 가장 중요하다고 판단되는 일부 관계만을 선별적으로 계산하는 방식이랍니다. 마치 수천 페이지짜리 보고서에서 모든 단어를 다 읽는 대신, 핵심 문장과 중요 부분만 쏙쏙 뽑아 읽는 것과 비슷하다고 할 수 있어요.

예를 들어, 5,000번째 단어를 처리할 때 기존 방식이 앞선 4,999개의 모든 단어와 관계를 확인했다면, 희소 어텐션은 모델 스스로가 가장 관련성이 높은 100개의 단어만 골라서 관계를 분석하는 식이죠. 이렇게 되면 불필요한 연산량을 획기적으로 줄일 수 있어서 AI 모델의 처리 속도를 높이고, 그에 따라 드는 연산 자원과 비용을 대폭 절감할 수 있게 됩니다. 이는 장문 처리 능력과 AI 효율성을 향상시키는 데 큰 도움이 돼요.

딥시크의 ‘라이트닝 인덱서’: 똑똑하게 핵심만 골라내는 비법

희소 어텐션이 단순히 ‘일부만 본다’는 개념만으로는 제대로 작동하기 어렵겠죠? 어떤 관계를 ‘선택’하고 어떤 관계를 ‘생략’할지 똑똑하게 판단하는 것이 중요한데요. 딥시크는 이러한 판단을 돕는 독자적인 기술인 ‘라이트닝 인덱서(Lightning Indexer)’를 개발했어요. 이 라이트닝 인덱서는 작은 신경망 구성 요소로, 단어 쌍 간의 관련성을 점수화하고 각 단어에 대해 가장 중요한 2,048개의 연결을 선별해낸다고 합니다.

딥시크는 자신들의 딥시크 희소 어텐션(DSA) 기술이 ‘최초로 세밀한(fine-grained) 희소 어텐션’을 구현했다고 주장해요. 즉, 단순한 규칙이 아니라 AI 모델 스스로 학습을 통해 가장 중요한 연결을 정확하게 식별하고, 이를 통해 모델의 이해도를 떨어뜨리지 않으면서도 불필요한 연산을 효과적으로 건너뛸 수 있게 된 것이죠. 덕분에 딥시크는 AI 모델의 성능 저하 없이 효율성을 극대화할 수 있었답니다.

성능은 유지하고 비용은 절반! 딥시크의 놀라운 실험 결과

딥시크는 실험적인 모델인 DeepSeek-V3.2-Exp를 출시하며 자신들의 희소 어텐션 기술력을 입증했어요. 자체 벤치마크 결과, 이 실험 모델은 희소 어텐션 기술을 적용했음에도 불구하고 기존 V3.1-Terminus 모델과 비슷한 수준의 성능을 유지했다고 해요. 특히 주목할 만한 점은 긴 문맥(long-context) 환경에서 API 사용 비용을 최대 절반까지 줄일 수 있었다는 결과랍니다. 이는 엄청난 AI 처리 비용 절감 효과를 가져올 수 있음을 시사해요.

게다가 딥시크는 OpenAI나 Anthropic과 달리 자신들의 고성능 AI 모델에 MIT 라이선스의 오픈 소스 구성 요소와 오픈 가중치를 포함시켰어요. 이는 다른 연구자들이 딥시크의 연구를 바탕으로 추가 개발을 할 수 있도록 문을 열어준 것이어서, AI 기술 발전에도 긍정적인 영향을 미칠 것으로 기대된답니다. 물론 딥시크의 자체 테스트 결과인 만큼, 제3자 연구자들의 독립적인 검증이 필요하지만, 그 잠재력은 충분히 놀랍다고 할 수 있죠.

AI 효율의 새 지평: 희소 어텐션이 가져올 미래

딥시크의 희소 어텐션 기술은 단순히 AI 모델의 속도를 빠르게 하거나 비용을 줄이는 것을 넘어, AI 기술의 대중화와 접근성을 높이는 중요한 계기가 될 수 있어요. 컴퓨팅 자원 제약으로 고성능 AI 모델 개발이 어려웠던 기업이나 연구팀에게는 희망적인 소식이 될 것입니다. 특히 긴 문서를 요약하거나 복잡한 대화를 처리하는 AI 어플리케이션 분야에서 희소 어텐션은 더욱 빛을 발할 거예요.

앞으로 희소 어텐션 기술이 더욱 발전하고 널리 적용된다면, 우리는 더 저렴하고 효율적인 AI 서비스를 일상에서 만날 수 있을 겁니다. AI 모델의 ‘뇌’ 역할을 하는 어텐션 메커니즘의 진화가 어디까지 이어질지, 딥시크의 행보에 귀추가 주목되네요! 여러분은 이 기술이 우리의 삶을 어떻게 바꿀 것이라고 생각하시나요? 댓글로 의견을 나눠봐요!

출처: https://arstechnica.com/ai/2025/09/deepseek-tests-sparse-attention-to-slash-ai-processing-costs/