2026년 2월 기준으로 로컬 AI 구동 환경에 큰 변화가 생겼네요. 이번에 공개된 LM Studio 0.4.0 업데이트는 단순히 기능이 늘어난 수준이 아니라 아키텍처 자체가 완전히 바뀌었더라고요. 서버처럼 백그라운드에서 돌리거나 여러 작업을 동시에 처리하는 기능이 추가되면서 개인용 워크스테이션의 활용도가 엄청나게 높아졌어요.

LM Studio 0.4.0 왜 이토록 강력해졌을까요?

가장 큰 변화는 역시 한꺼번에 여러 질문을 처리할 수 있는 병렬 추론 능력이 생겼다는 점이에요. 예전에는 질문 하나를 던지면 답변이 끝날 때까지 기다려야 했지만 이제는 여러 요청이 들어와도 동시에 처리하는 연속 배치 기술이 도입되었거든요.

- 고성능 서버급 처리를 위한 병렬 요청 지원

- GUI 없이 실행 가능한 독립형 데몬 서비스 제공

- 대화 맥락을 완벽하게 기억하는 새로운 API 규격

- 사용자 편의를 극대화한 분할 뷰 인터페이스

이런 기능들이 하나로 합쳐지면서 이제는 굳이 클라우드 AI를 쓰지 않아도 내 컴퓨터만으로 충분히 강력한 서비스를 만들 수 있는 토대가 마련되었어요.

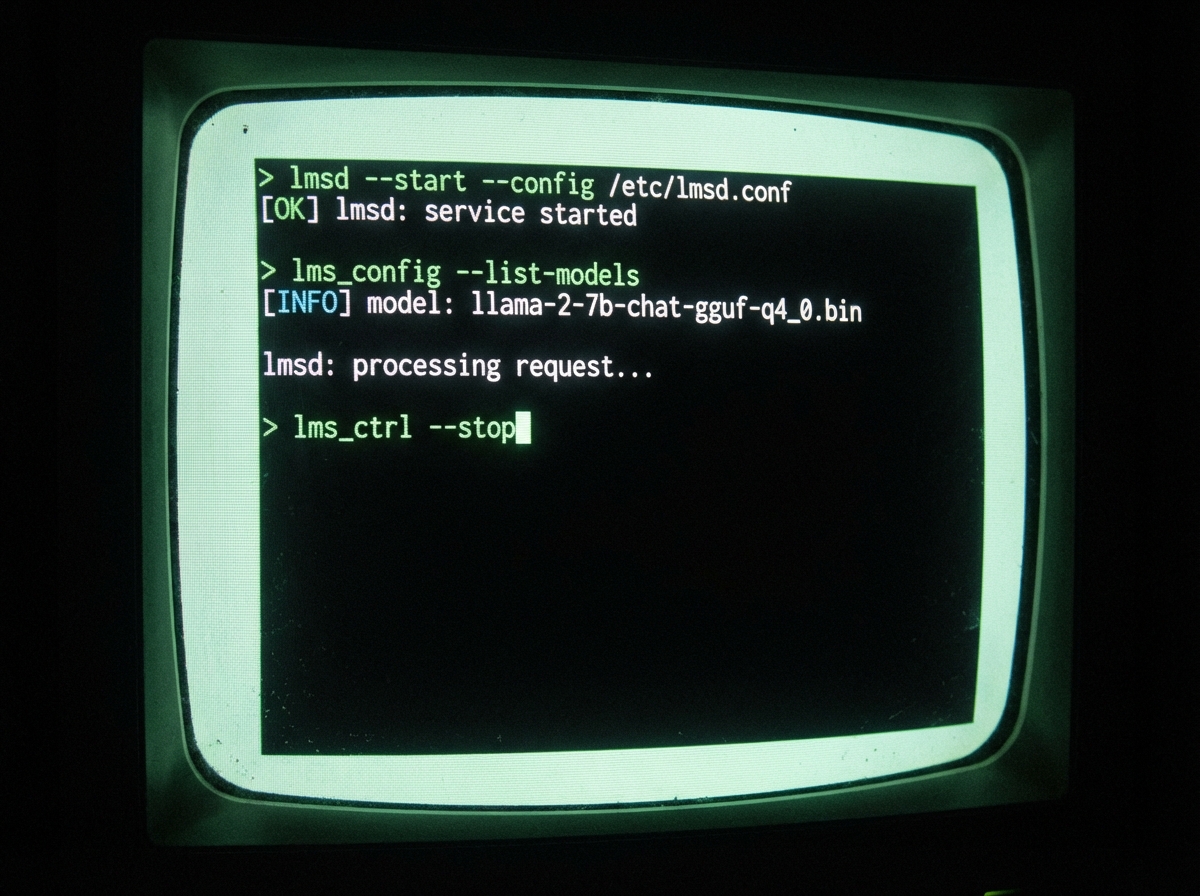

llmster 활용해 GUI 없이 백그라운드 실행하기

이번 업데이트에서 가장 흥미로운 부분은 llmster라는 이름의 코어 엔진이 분리된 것이었어요. 화면이 있는 앱을 굳이 띄우지 않아도 터미널 환경에서 AI를 구동할 수 있거든요. 설치 방법도 아주 간단하더라고요.

- 리눅스나 맥 사용자는 터미널에

curl -fsSL https://lmstudio.ai/install.sh | bash를 입력하세요. - 윈도우 환경이라면 파워쉘에서

irm https://lmstudio.ai/install.ps1 | iex명령어를 실행하면 돼요. - 설치 후에는

lms daemon up명령어로 서버를 즉시 가동할 수 있어요.

이렇게 실행하면 메모리 점유율도 낮아지고 서버나 클라우드 인스턴스에서도 LM Studio의 강력한 기능을 그대로 쓸 수 있게 된답니다.

병렬 요청 기능으로 작업 처리량 극대화하는 법

LM Studio 0.4.0 버전의 핵심인 병렬 추론 기능을 제대로 쓰려면 모델 로딩 설정을 살짝 손봐야 해요. 모델을 불러올 때 나타나는 설정 창에서 ‘Max Concurrent Predictions’라는 항목을 찾으면 되더라고요.

- 최대 동시 요청 수 설정: 기본값 4에서 하드웨어 성능에 따라 조절 가능

- 통합 KV 캐시 사용: 메모리 자원을 효율적으로 나눠 써서 낭비 최소화

- 연속 배치 기술: 여러 사용자가 접속해도 대기 시간 없이 즉시 응답

이 기능을 켜두면 여러 대화창을 동시에 띄워놓고 질문을 던져도 막힘없이 술술 답변이 나오는 것을 확인할 수 있었어요.

새로운 스테이트풀 API로 맥락 있는 대화하기

개발자분들에게는 /v1/chat이라는 새로운 API 엔드포인트가 정말 반가운 소식일 거예요. 기존의 방식과 달리 대화의 상태를 서버가 기억해주기 때문이죠.

- 대화 시작 후 받은 response_id를 다음 요청에 포함하면 흐름이 유지돼요.

- 로컬 MCP를 지원해서 내 컴퓨터의 파일이나 도구와 연동하기 쉬워졌어요.

- 토큰 생성 속도나 성능 통계를 상세하게 제공해서 최적화가 편하더라고요.

덕분에 복잡한 챗봇 서비스를 만들 때 이전 대화 내용을 일일이 다시 보낼 필요가 없어졌어요. 데이터 전송량도 줄고 처리 속도도 훨씬 빨라지는 효과가 있었죠.

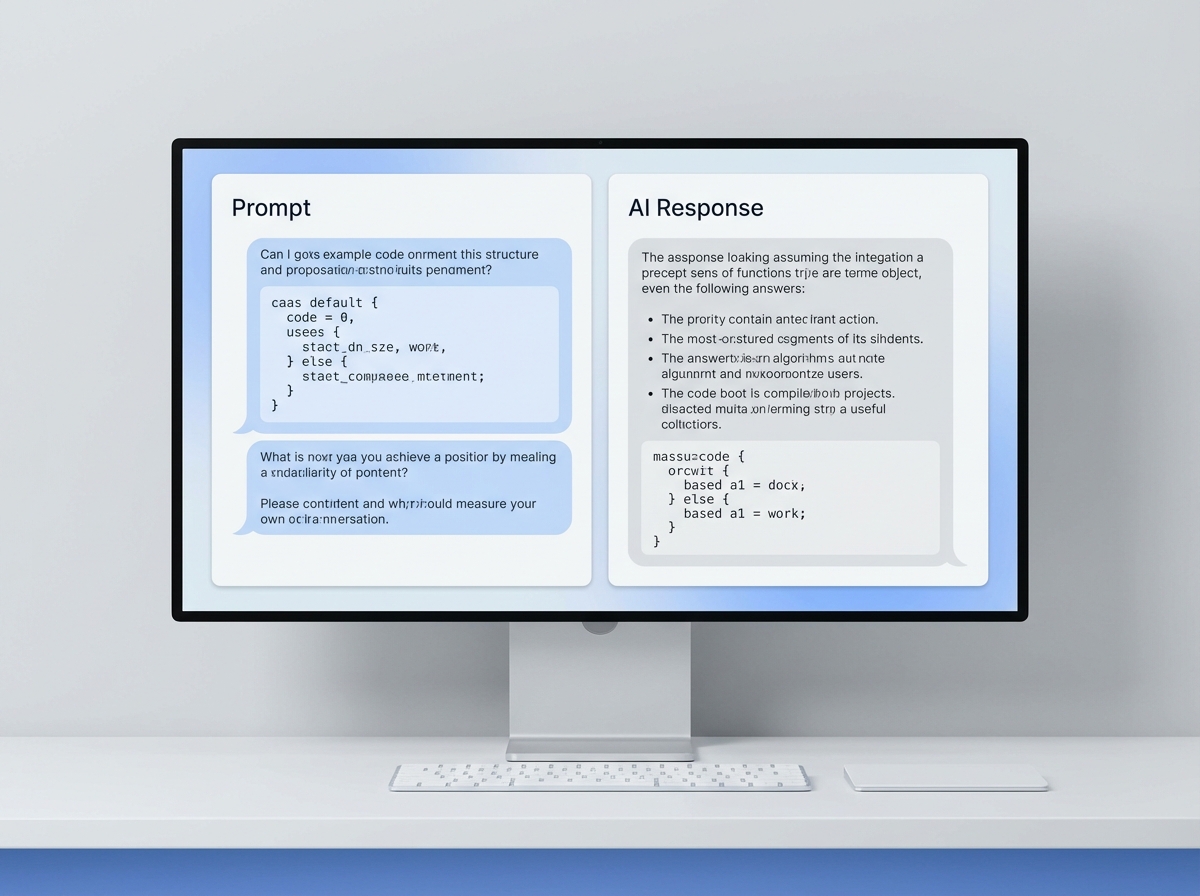

UI 리프레시와 분할 뷰 기능을 활용하는 팁

화면 구성도 완전히 새로워졌는데 특히 분할 뷰 기능이 정말 편했어요. 화면 오른쪽 상단의 아이콘을 누르면 채팅창이 반으로 나뉘면서 두 가지 모델을 비교하거나 다른 대화를 동시에 진행할 수 있거든요.

효율적인 업무를 위한 UI 활용법

- 분할 뷰: 왼쪽에는 코드 작성을, 오른쪽에는 문서 요약을 띄워보세요.

- 개발자 모드: 설정에서 이 모드를 켜면 상세한 로딩 파라미터를 조절할 수 있어요.

- 인앱 문서: 앱 안에서 바로 API 사용법이나 설정 가이드를 읽을 수 있더라고요.

사용자 인터페이스가 훨씬 정돈되어서 그런지 오래 작업해도 눈이 덜 피로하고 원하는 기능을 찾기도 훨씬 수월해진 느낌이었어요.

대화 기록을 다양한 문서 형식으로 내보내는 법

정성껏 나눈 대화 내용을 기록으로 남기고 싶을 때가 많죠. 이제는 채팅창 메뉴에서 ‘Export’를 클릭하기만 하면 간단하게 파일로 만들 수 있게 되었어요.

- PDF 형식: 보고서나 증빙용으로 깔끔하게 저장하고 싶을 때 좋아요.

- 마크다운: 블로그 포스팅이나 깃허브 기록용으로 복사해서 쓰기 편하더라고요.

- 일반 텍스트: 가볍게 내용만 보관하고 싶을 때 선택하면 된답니다.

이미지가 포함된 대화도 PDF로 깔끔하게 변환되는 것을 보고 이번 업데이트의 완성도가 정말 높다는 생각이 들었어요.

마치며

LM Studio 0.4.0 버전은 이제 단순한 모델 실행기를 넘어 하나의 완성된 플랫폼으로 진화했다는 인상을 받았어요. 특히 llmster 데몬과 병렬 처리 기능은 로컬 환경에서도 상용 서비스 못지않은 성능을 내주더라고요. 그동안 속도나 편의성 때문에 클라우드 서비스를 쓰셨던 분들도 이번 기회에 나만의 강력한 로컬 AI 서버를 구축해 보시면 좋을 것 같아요. 최신 기능을 직접 체험해 보면서 나에게 딱 맞는 AI 환경을 만들어 보세요.

이어서 보면 좋은 글

#LMStudio040 #로컬AI #AI서버 #llmster #인공지능 #LLM #딥러닝 #IT트렌드 #기술블로그 #개발자꿀팁